Métodos para la Explicabilidad de modelos de Inteligencia Artificial

La explicabilidad en los modelos de inteligencia artificial (IA) se ha convertido en un tema crucial, especialmente en contextos donde la transparencia y la comprensión del proceso de toma de decisiones son fundamentales. A continuación, exploramos los métodos más utilizados para hacer más comprensibles los modelos de IA, dividiéndolos en dos categorías principales: métodos globales y métodos locales.

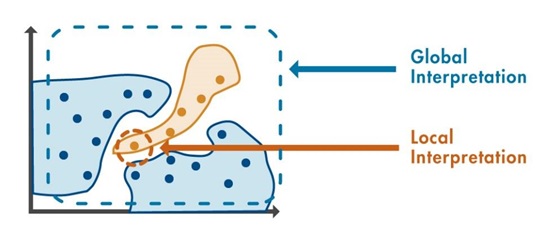

Métodos Globales y Locales

Métodos Globales: Estos métodos ofrecen una visión general del comportamiento del modelo, proporcionando información sobre las variables que más influyen en las predicciones a nivel general, es decir, a través de todo el conjunto de datos.

Métodos Locales: Se enfocan en explicar una predicción específica de una sola instancia o punto de datos. Son útiles cuando necesitamos entender cómo llegó un modelo a una decisión particular.

Figura 1: La diferencia entre métodos globales y locales radica en el número de predicciones analizadas

Métodos Globales para la Explicabilidad

Uno de los métodos globales más utilizados es la clasificación de variables. Este método organiza las características o variables del modelo en función de su impacto relativo sobre las predicciones. Al identificar qué variables son las más influyentes, los ingenieros pueden obtener una visión más clara de cómo las entradas afectan el comportamiento del modelo.

Otro enfoque global relevante son las Gráficas de Dependencia Parcial (PDP). Estas gráficas permiten visualizar cómo una característica específica influye en la predicción del modelo a lo largo del rango de sus valores, lo que facilita la interpretación del comportamiento del modelo en diferentes escenarios.

Métodos Locales para la Explicabilidad

Dentro de los métodos locales, los más conocidos y ampliamente utilizados son:

- LIME (Local Interpretable Model-agnostic Explanations): LIME es un enfoque que se utiliza tanto en el aprendizaje automático como en redes neuronales profundas. La idea detrás de LIME es aproximar un modelo complejo con un modelo simple y explicable en el contexto de un punto de interés. Esto ayuda a identificar qué predictores son los más relevantes para una predicción específica.

- Valores de Shapley: Los valores de Shapley provienen de la teoría de juegos y son útiles para medir la contribución de cada característica a una predicción. En otras palabras, explican la desviación de la predicción de un modelo con respecto a su predicción promedio. Este método se usa para entender cómo cada variable individual influye en una predicción en particular, lo que ayuda a descomponer el modelo de forma comprensible.

Visualización para la Explicabilidad

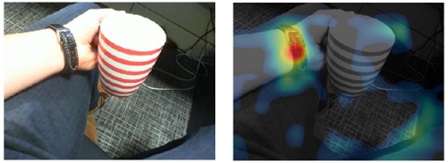

En proyectos de procesamiento de imágenes o visión artificial, las visualizaciones juegan un papel fundamental en la explicabilidad. Algunas de las técnicas de visualización más utilizadas incluyen:

Grad-CAM: Es un método visual que destaca las áreas clave de una imagen que influyen más en la predicción de un modelo de visión artificial. Al generar mapas de calor sobre la imagen, se puede identificar visualmente qué partes de la imagen son relevantes para la toma de decisiones del modelo.

Sensibilidad de Oclusión: Este método evalúa cómo la predicción de un modelo cambia al bloquear partes específicas de la imagen, lo que ayuda a identificar qué regiones son más influyentes para el modelo.

Figura 2. Técnicas de visualización para proveer información en la detección de errores de predicción.

Técnicas Adicionales: Agrupamiento y Comparación de Variables

Una de las técnicas más utilizadas en la exploración de datos multidimensionales es el T-SNE (t-Distributed Stochastic Neighbor Embedding). Este método permite reducir la dimensionalidad de los datos y representar relaciones complejas entre variables en un espacio bidimensional. T-SNE es particularmente útil para identificar patrones en grandes volúmenes de datos, lo que facilita la comparación entre variables y su influencia en el modelo.

Conclusión

Existen numerosas técnicas disponibles para mejorar la explicabilidad de los modelos de IA. Desde métodos simples como la clasificación de variables hasta técnicas complejas como LIME y los valores de Shapley, el objetivo común de estas herramientas es proporcionar una mayor transparencia en el funcionamiento de los modelos. Independientemente del algoritmo utilizado, todas estas metodologías buscan mejorar la comprensión de los datos y del modelo, lo que aumenta la confianza en las predicciones realizadas.

El uso adecuado de estas técnicas durante el desarrollo y la evaluación de modelos puede contribuir significativamente a una mejor comprensión del comportamiento de la IA, lo que es fundamental para la toma de decisiones informadas y el cumplimiento de normas regulatorias.